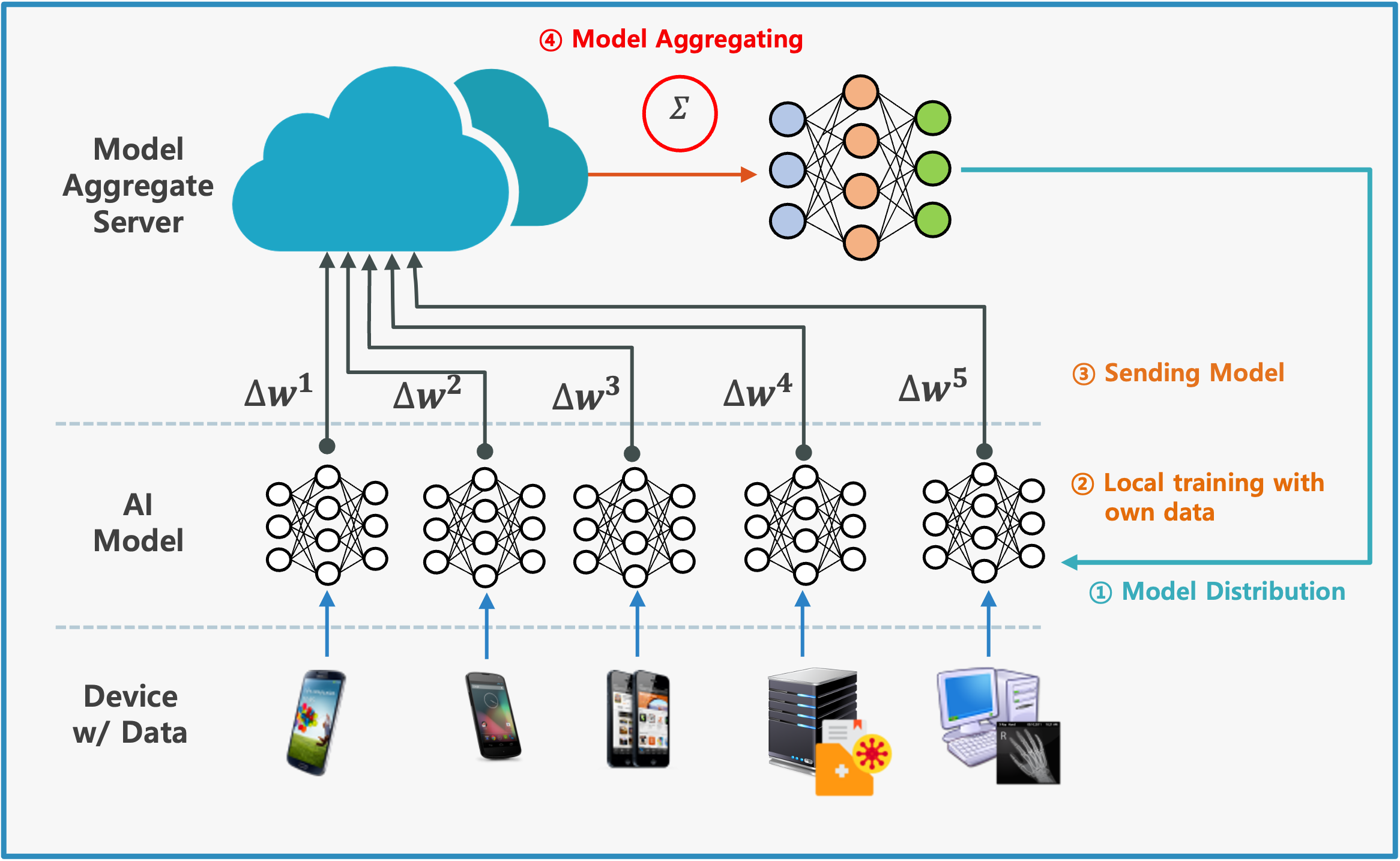

요약 클라이언트들에게 최근의 Global representation을 제공하고, Client drift를 방지하는 것을 목표로 함. 기존에 연합학습에 Knowledge Distillation을 적용하는데 있어 마지막 logit에 대해서만 수행하는 것을 Model을 블록화 시키고, 이를 Hybrid Pathway로 구성하여 Knowledge Distillation을 포함한 학습을 진행함 1. Motivation Goal is to make each client preserve the latest global representations and prevent model drift caused by independent local updates Server learns client-specific knowle..