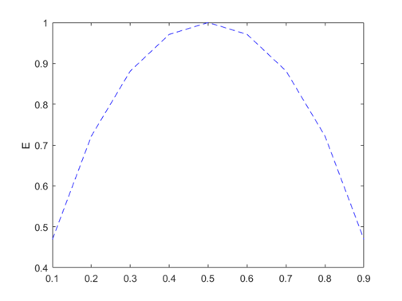

엔트로피(Entropy)의 정의 엔트로피는 물질이나 시스템의 무질서함이나 혼란도를 나타내는 물리적, 그리고 정보이론적 개념이다. 열역학에서는 일반적으로 물질의 무질서함이나 에너지의 확산정도를 나타낸다. 정보 이론에서는 데이터의 불확실성을 측정하는 값이다. 엔트로피가 높다는 것은 불확실성이 높다는 것을 의미한다. 우리는 인공지능에서의 엔트로피를 말하기 위해 정보이론에서의 엔트로피를 다루도록 한다. 정보 이론에서 엔트로피는 샤넌 엔트로피(Shannon entropy)[1]로 불리기도한다. 샤넌 엔트로피는 확률 분포를 사용하여 불확실성의 정도를 측정하는데, 이산 확률 분포에 대한 샤넌 엔트로피는 다음과 같이 나타 낼 수 있다. $$ H(X) = -\sum P(X) log_2P(X)$$ 여기서 $H(X)$는 확..